Étude de cas : La puissance de la combinaison de la simulation et de l'apprentissage par renforcement

Qu'est-ce qu'un modèle de simulation?

La modélisation de simulation est une technique qui permet de trouver des solutions aux problèmes du monde réel. Dans de nombreux cas, nous ne pouvons pas expérimenter dans le monde réel, et nous aimerions donc créer un modèle de ce système réel et expérimenter avec le modèle. Ce modèle informatique représente un "monde sans risque". Le modèle sera toujours moins complexe que le monde réel, car nous laisserons de côté les détails que nous jugeons inutiles pour l'effet que nous voulons étudier. Cependant, la possibilité de tester des solutions dans un monde sans risque n'est pas la seule raison pour laquelle nous créons des modèles de simulation. Les problèmes du monde réel sont complexes et, souvent, il n'y a pas d'autre moyen de les résoudre. La simulation permet de modéliser des systèmes complexes et, en jouant avec ce système, de voir la trajectoire des états du système dans le temps. De cette manière, nous pouvons développer une meilleure intuition des relations de cause à effet et atteindre la solution optimale.

Apprentissage par renforcement

L'apprentissage par renforcement est une technique d'apprentissage automatique dans laquelle l'agent d'apprentissage apprend quelles actions entreprendre pour maximiser un signal de récompense numérique.

Elle repose sur l'idée de formuler les problèmes comme un processus de décision de Markov dans lequel un agent d'intelligence artificielle (un algorithme spécialisé) apprend une politique de contrôle afin de toujours choisir la meilleure action possible pour un état donné du système. Idéalement, ce système est quelque peu aléatoire et dynamique, ce qui rend l'approche d'apprentissage basée sur la récompense supérieure à d'autres théories de contrôle traditionnelles. L'application réussie des réseaux neuronaux en conjonction avec l'apprentissage par renforcement (d'où le nom "Deep Reinforcement Learning") a ouvert de nouveaux horizons pour traiter des scénarios plus complexes qui étaient auparavant considérés comme impossibles. L'apprentissage par renforcement en profondeur (DRL) suit cette méthode, en utilisant un réseau neuronal profond pour représenter la politique.

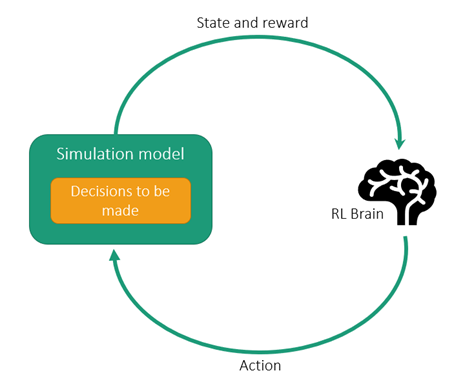

La simulation comme environnement de formation pour l'apprentissage par renforcement

L'apprentissage par renforcement (RL) nécessite un grand nombre d'épisodes d'essais et d'erreurs ou d'interactions avec les environnements pour apprendre une bonne politique. Les simulateurs sont donc nécessaires pour obtenir des résultats en temps voulu et de manière rentable. Le modèle de simulation devient essentiellement l'environnement dans lequel l'agent d'apprentissage par renforcement va apprendre.

Comme le modèle RL apprend par un processus continu de récompenses pour chaque action entreprise, il peut apprendre à réagir à des environnements imprévus. Les systèmes industriels, y compris la gestion de la chaîne d'approvisionnement et les processus industriels, sont de bons exemples de problèmes vastes et complexes qui conviennent parfaitement à l'apprentissage par renforcement.

Dans le cas de la gestion de la chaîne d'approvisionnement, il serait extrêmement difficile, voire impossible, d'écrire un programme capable de gérer efficacement toutes les combinaisons possibles de circonstances survenant dans les scénarios quotidiens. Les camions peuvent tomber en panne, la nourriture peut se gâter, le mauvais temps peut entraîner des fermetures de routes - la liste des situations potentielles est pratiquement infinie. La liste des situations potentielles est pratiquement infinie. Par conséquent, le système doit être hautement adaptatif. Là encore, les techniques d'apprentissage par renforcement sont particulièrement utiles, car elles ne nécessitent pas beaucoup de connaissances ou de données préexistantes pour fournir des recommandations et des solutions utiles.

Voici quelques situations dans lesquelles il est recommandé d'adopter une approche basée sur la simulation et la logique logique :

- Exigences de robustesse extrême : Un système de contrôle ou un moteur d'optimisation existant nécessite de nombreux réglages différents pour fonctionner correctement dans toutes les conditions.

- Objectifs d'optimisation multiples ou changeants : Un système de contrôle existant a du mal à optimiser vers des objectifs multiples ou les objectifs d'optimisation changent en fonction des conditions environnementales.

- Surcharge de l'opérateur : Les opérateurs ne peuvent pas traiter de nombreuses variables en temps réel tout en contrôlant les systèmes ou les ingénieurs ont besoin d'aide pour prendre des décisions dans différents scénarios.

- Tâches pour lesquelles une personne peut surpasser les méthodes d'optimisation traditionnelles : Ces tâches pourraient être rendues autonomes à l'aide d'une approche basée sur le RL.

Si vous pensez que vous et votre organisation pourriez tirer profit de l'apprentissage par le renforcement grâce à la simulation, contactez-nous pour savoir par où commencer.